谷歌 DeepMind 发布 Gemini Diffusion:AI 文本生成的新范式

谷歌 DeepMind 昨日宣布了 Gemini Diffusion,这是一个实验性语言模型,首次将图像生成的“从噪声到信号”方法应用于文本的生产规模应用。这项突破有望大幅提升文本生成速度,同时改善连贯性,这可能颠覆多年来主导 AI 发展的大语言模型主流方法。

与传统的自回归模型一次生成一个 token 不同,Gemini Diffusion 通过迭代步骤将噪声提炼成连贯文本。谷歌称,这一过程的响应速度“甚至比我们目前最快的模型还要快得多”。

“这代表了我们思考语言生成的根本性转变,”一位熟悉 Diffusion 技术但不隶属于谷歌的资深 AI 研究员表示。“我们看到,与大小相似的自回归模型相比,端到端输出速度有望提升 4-5 倍。这相当于仅通过软件创新就跳跃了几个硬件代际。”

打破序列障碍

Gemini Diffusion 背后的技术创新解决了当前 AI 系统的核心局限性。像 GPT-4 或之前的 Gemini 版本这样的传统语言模型是按顺序工作的,根据前文预测每个词。这种方法虽然有效,但固有地限制了速度,并在生成长文本时可能导致连贯性问题。

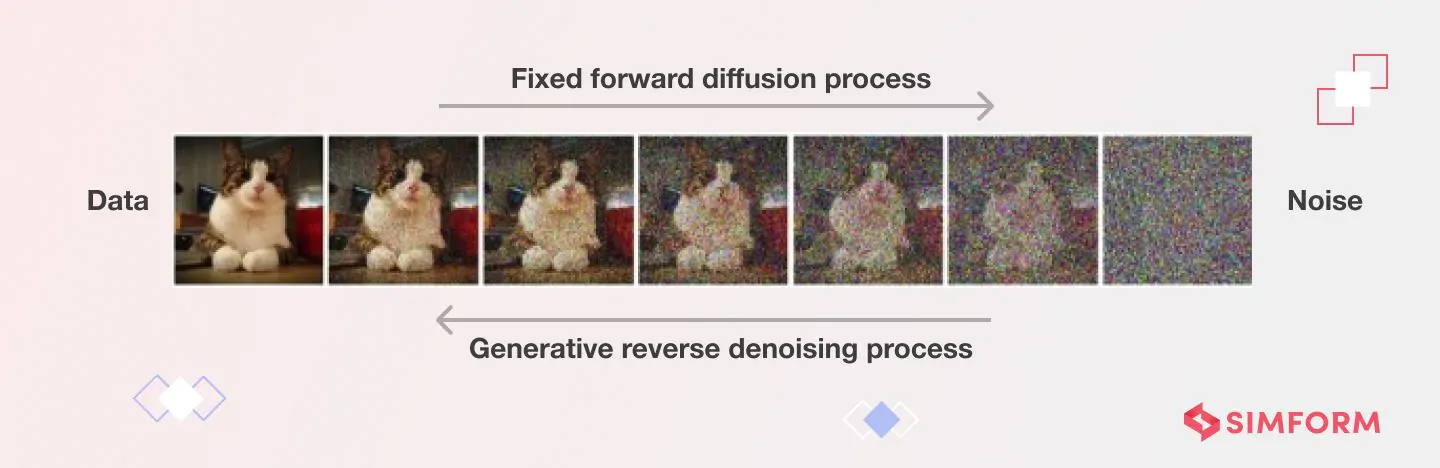

Diffusion 模型采用了一种截然不同的方法。它们不是逐块构建文本,而是从随机噪声开始,并通过重复的去噪步骤将其逐步提炼成有意义的内容。

“整个过程更像雕塑,而不是写作,”一位专注于 AI 架构的行业分析师解释说。“模型在每个提炼阶段都考虑完整上下文,这自然能实现纠错和整体连贯性,而这是逐 token 生成难以达到的。”

谷歌发布的基准测试结果显示,Gemini Diffusion 的平均采样速度达到每秒 1,479 token,这比之前的模型有了显著提升,尽管每次生成会伴随大约 0.84 秒的开销。

基准测试表现喜忧参半:优势与局限并行

谷歌的基准测试数据显示,Gemini Diffusion 的性能表现不均衡但有前景。该模型在编码任务中表现出特别的优势,在 HumanEval 测试中得分 89.6%,在 MBPP 测试中得分 76.0%,这几乎与 Gemini 2.0 Flash-Lite 的 90.2% 和 75.8% 分数相同。

然而,该模型在某些领域也表现出明显的弱点。在 BIG-Bench Extra Hard 推理测试中,Gemini Diffusion 得分 15.0%,而 Flash-Lite 为 21.0%。类似地,在 Global MMLU 多语言基准测试中,Diffusion 得分 69.1%,而 Flash-Lite 为 79.0%。

“我们看到的是一种特别擅长需要迭代精炼的任务的技术,比如编码,在全局上下文中进行局部微调很有价值,”一家大型金融机构的机器学习专家指出。“在推理任务上表现较弱表明,Diffusion 模型可能需要针对逻辑性强的应用进行架构调整。”

尽管存在这些局限性,谷歌 DeepMind 强调了该模型的参数效率,在许多领域取得了与大型自回归模型相当的基准测试分数。

文本扩散模型设计与实现中的技术挑战

| 挑战类别 | 具体挑战 | 描述 |

|---|---|---|

| 计算与效率 | 处理需求 | 需要数百到数千个去噪步骤,每个步骤都涉及神经网络的完整前向传播 |

| 延迟问题 | 推理速度可能非常慢,限制了实时应用 | |

| 内存消耗 | 在反向扩散的每个步骤中,中间特征图需要巨大的内存 | |

| 文本特定实现 | 架构局限性 | 由于非因果注意力计算,无法受益于 KV 缓存 |

| Q_absorb 转换局限性 | 只去噪一次 token,限制了编辑之前生成 token 的能力 | |

| 处理效率低下 | 被遮蔽的 token 不提供信息,但仍消耗计算资源 | |

| 固定生成长度 | 相较于自回归模型,是开放式文本生成的主要障碍 | |

| 控制与对齐 |