智谱清言GLM-4.6剑指硅谷AI编码优势——成本仅为零头

新模型在实际编码中媲美Claude Sonnet 4,同时将token使用量降低30%,助力中国AI冲击全球开发者市场。

中国人工智能产业发起了一项大胆挑战。智谱,作为中国最具雄心的AI公司之一,刚刚发布了GLM-4.6。据行业评估,这款专注于编码的模型在日常编程任务中与Anthropic的Claude Sonnet 4不相上下。更令人瞩目的是,它在实现这一目标的同时,将成本大幅削减了高达85%。

此次发布正值九月密集的模型发布季,此前已有OpenAI的GPT-5 Codex、Anthropic的Claude Sonnet 4.5和DeepSeek的V3.2相继问世。与早期围绕基准测试分数炫耀的竞争不同,现在的赛道正转向开发者真正关心的地方:那些能完成工作且价格亲民的工具。

令人瞩目的性能

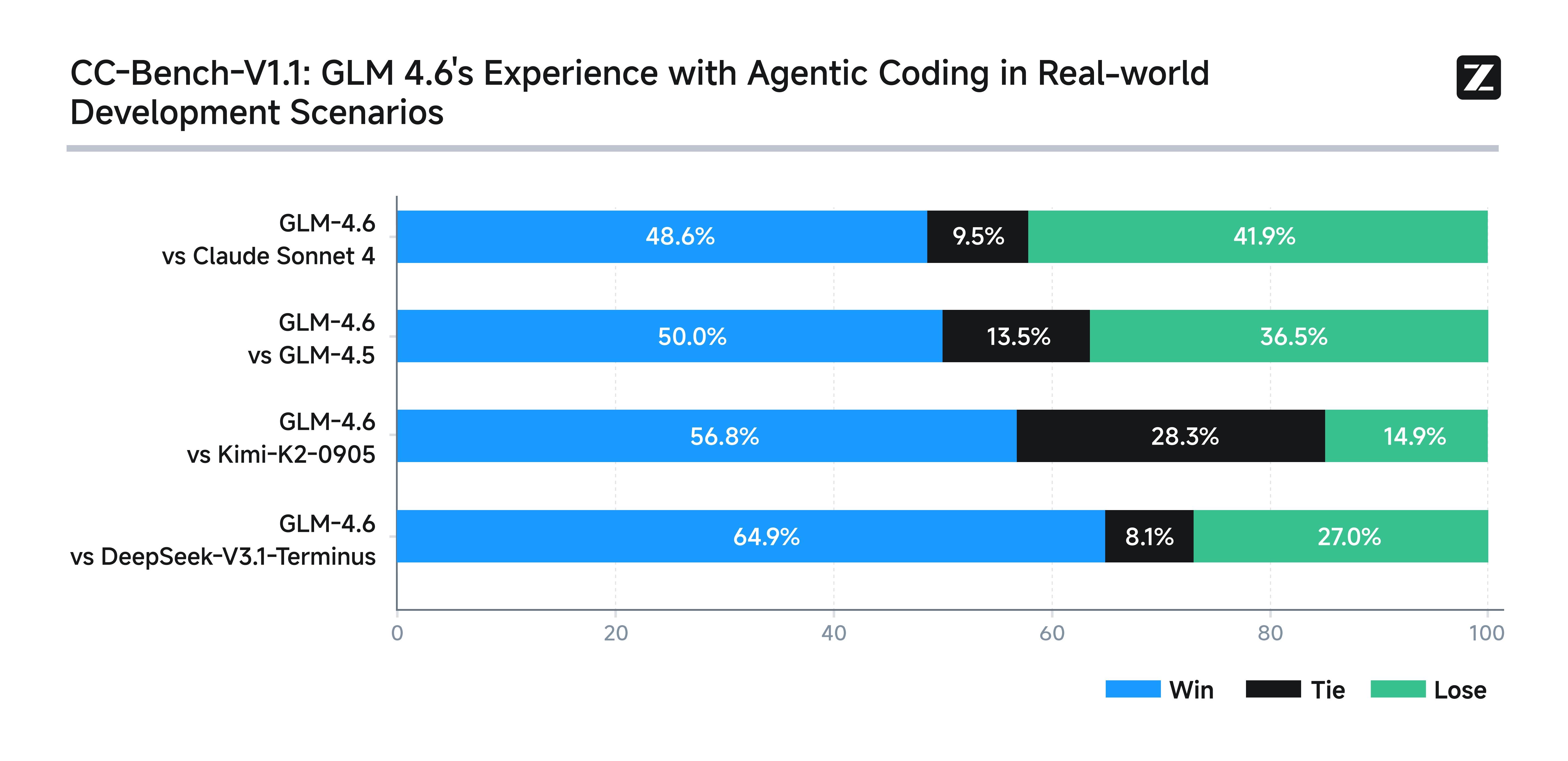

为测试GLM-4.6,智谱在Claude Code开发环境中设置了74项真实的编码挑战,并公开了结果至Hugging Face以供验证。结果令许多人感到惊讶:GLM-4.6不仅在多项任务中击败了Claude Sonnet 4,更是将所有其他中国竞争对手甩在了身后。

这些挑战并非枯燥的学术基准测试,而是模拟了开发者在实际工作中遇到的难题——例如构建用户界面、自动化文档处理以及创建数据密集型仪表板。

其中一项突出测试要求模型将一份64页的OpenAI研究论文压缩成一张简洁的HTML信息图。评估者称其结果“扎实且结构良好”。尽管在视觉精美度上不如Claude Sonnet 4.5的输出,但它击败了成本高出数倍的模型。

在另一项测试中,该模型构建了一个“2024年国庆旅游”数据仪表板,包含动画和密集图表。独立评审员表示,GLM-4.6的表现与Claude Sonnet 4.5不相上下——这对于任何依赖时尚、功能性仪表板的企业来说都是一项重大成就。

然而,并非所有方面都完美无缺。在广泛使用的编码基准SWE-bench Verified上,GLM-4.6得分为68%,与DeepSeek-V3.2持平,但低于Claude Sonnet 4.5的77.2%。

效率:秘密武器

GLM-4.6真正的亮点在于其效率。与前一代GLM-4.5相比,它的token消耗量减少了约30%。对于推理任务,下降幅度更大:从16,000 tokens降至仅9,000 tokens。这使其成为市场上最精简的中国推理模型。

响应时间约为35秒——足以使其跻身更快的“二线”模型之列。

正如CTOL.digital的一位工程团队成员所说:“开发者不再只想要排行榜上的冠军。他们需要能够处理真实对话、协同工具工作且不烧钱的模型。” GLM-4.6似乎满足了这些要求。

颠覆市场的价格

效率意味着节约成本,智谱也将这些优势转化为了实惠。其GLM编程计划现在每月仅需20元(约合三美元)起。这大约是竞争对手成本的七分之一。该计划每月提供“数百亿乃至上千亿”的tokens,对于大多数全职开发者而言,这是一个非常慷慨的额度。

除此之外,订阅还包含视觉识别、搜索功能以及与Claude Code、Roo Code和Cline等工具的即插即用集成。对开发者而言,其价值主张很简单:以极低的成本获得接近Claude 4的性能。

技术升级与权衡

智谱不仅调整了定价。GLM-4.6将其上下文窗口从128,000 tokens扩展到200,000 tokens,超越了DeepSeek-V3.2的128,000 tokens。这使其能够一次性处理庞大的代码库或冗长的文档。

与早期版本相比,该模型在指令遵循、算术能力和更简洁的语言输出方面均有所增强。但也有不足之处。在各种编程语言中,语法错误率跃升至13%,而GLM-4.5仅为5.5%。Go语言的开发者对此感受可能尤为明显。

还有另一个特点:在漫长复杂的推理任务中,GLM-4.6有时会提早退出,而不是强行寻找答案。评审员称之为一种“妥协倾向”——这很可能是其激进token优化的代价。

更宏大的图景:芯片自主

表面之下,隐藏着一个更具战略意义的因素:芯片独立性。GLM-4.6是首个在寒武纪芯片上运行FP8+Int4混合精度推理的生产模型,它也能使用vLLM在摩尔线程硬件上以FP8原生运行。

如果这些优化措施得以维持,中国公司最终可能会摆脱对英伟达GPU的依赖——考虑到美国的出口限制,这是一个关键的脆弱点。正如CTOL.digital工程团队总结的那样:“如果训练和推理都能在国内芯片上流畅运行,中国就能构建一个更自主的AI技术栈。”

竞争白热化

九月的模型发布潮凸显了AI编码竞赛的激烈程度。DeepSeek-V3.2将API价格削减了一半以上;OpenAI的GPT-5 Codex引入了“思考”token修剪以降低成本;Anthropic的Claude Sonnet 4.5则在复杂推理方面取得了进展。

曾被视为追随者的中国企业,如今正以吸引全球目光的方式进行创新。GLM-4.6在效率、芯片集成和低价方面的结合并非偶然——这是赢得全球开发者青睐的明确战略的一部分。

该模型已经上线:国际用户可在z.ai访问,中国用户可在bigmodel.cn访问,开源版本也已登陆Hugging Face和ModelScope。消费者聊天应用和企业API也在推广使用该模型。

开发者反馈

实际操作反馈令人鼓舞。开发者反映,前端生成更流畅,卡顿更少,并且能快速在Vue 3等现代框架中重建旧项目。一些开发者甚至构建了完整的工具使用型智能体,可以顺利抓取数据并生成本地文档。

在前端场景中,GLM-4.6常常媲美甚至超越Claude 4。然而,在繁重推理和长文档任务方面,Claude Sonnet 4.5仍保持其优势。

总结

在当今的AI格局中,原始算力不再是唯一的决定因素。部署策略、效率和成本同样重要。GLM-4.6在这三者之间取得了平衡。它并非绝对的顶尖性能模型,但在大多数情况下已足够接近——而且价格便宜得多。

对于许多开发者来说,这种结合将是不可抗拒的。一位分析师称其为“最实用的国产编码模型”,也是西方产品的有力挑战者。

这是否标志着中国AI长期竞争力的开始,抑或只是暂时的优势,仍有待观察。但有一点是明确的:在2025年10月,GLM-4.6已经改变了开发者对前沿AI编码付费的预期。